Документ «Передача в производство» — ДАЛИОН: ТРЕНД

Документ «Передача в производство» используется для оформления перемещения товаров со склада хранения на склад производства.

Документ может быть создан через одноименный журнал подсистемы «Производство» и на основании документов «План производства», «Выпуск продукции».

ВАЖНО

Для работы с документом у пользователя должна быть активна роль Добавление и изменение документа «Передача в производство».

В шапке документа пользователь указывает склад, с которого будут списаны товары, и склад-получатель, на который товары будут оприходованы.

В табличную часть добавляем товары и указываем количество для перемещения. Товары могут быть добавлены вручную по кнопке «Добавить», подбором из справочника «Номенклатура» или из ТСД – «Заполнить/Получить данные из ТСД»).

На склад производства приходуется ингредиент, в качестве которого может выступать как «реальный» товар с признаком Участвует в производстве

скриншот выше).

скриншот выше).Примечание

Если приходуемый ингредиент является «виртуальным», то расходуемый товар может быть, как «виртуальным», так и «реальным». Если приходуемый ингредиент – «реальный», то в расходе может быть только он сам.

По кнопке «Дополнить расход штучных товаров до базовых единиц» количество штучных товаров будет округлено до целых (кратно базовой единице товара).

Передача в производство происходит по фактической себестоимости товара. Обратите внимание, что в оперативном периоде себестоимость не рассчитывается, она будет зарегистрирована в программе после проведения расчета финансового результата, который распределит товары по партиям.

Документом «Передача в производство» регистрируются закупочные цены ингредиентов. Активный флаг Регистрировать закупочные цены (на закладке «Дополнительно») – стоимость перемещенного товара будет зарегистрирована как закупочная цена ингредиента. Флаг активен по умолчанию.

В подвал документа выводится информация о закупочной цене списываемого товара и приходуемого ингредиента. Эти данные позволят принимать решения:

Эти данные позволят принимать решения:

- об изменении закупочной цены ингредиента,

- о выборе другого аналога для ингредиента.

Из документа можно сформировать печатную форму передачи в производство: по ценам реализации и по себестоимости, а также сформировать переоценку.

При необходимости пользователь может проанализировать список переданных на нужды производства товаров, построив соответствующий отчет.

Примечание

Если в производстве фигурирует алкоголь, на основании передачи в производство можно создать документ «Акт списания». Списание будет произведено с видом

Документ «Передача в производство» может быть создан на основании документов: «План производства» и «Выпуск продукции».

Примечание

Товар перемещается с места хранения на склад производства в соответствии с правилом товародвижения.

В том случае, если в рамках склада производства для ингредиента определена связь с аналогом, при формировании передачи в производство будет сделана передача аналога на полное количество ингредиента.

Если на складе хранения есть необходимое количество товара для выпуска, то оно будет перемещено на склад производства, при этом:

- переданное количество «реального» товара будет кратно его базовой единице измерения,

- перемещенное количество аналога ингредиента будет кратно его базовой единице измерения.

Возможные сценарии отработки данного механизма:

- Если в процессе формирования передачи появилось сообщение о пропуске товара, значит, на складе производства существует нехватка «реального» товара, для которого не задано правило товародвижения.

Если в процессе создания передачи в производство появилось информационное окно, в котором необходимо выбрать место хранения для ингредиентов без аналогов, значит, в рамках склада производства для ингредиента не определена связь с аналогом и необходимо выбрать склад хранения, с которого будет перемещен аналог для этого ингредиента.

Примечание

Необходимость такого выбора появляется тогда, когда на основании плана производства формируется передача с нескольких складов хранения. Если все товары будут переданы с одного места хранения, то аналог для ингредиента будет по умолчанию взят с этого же склада.

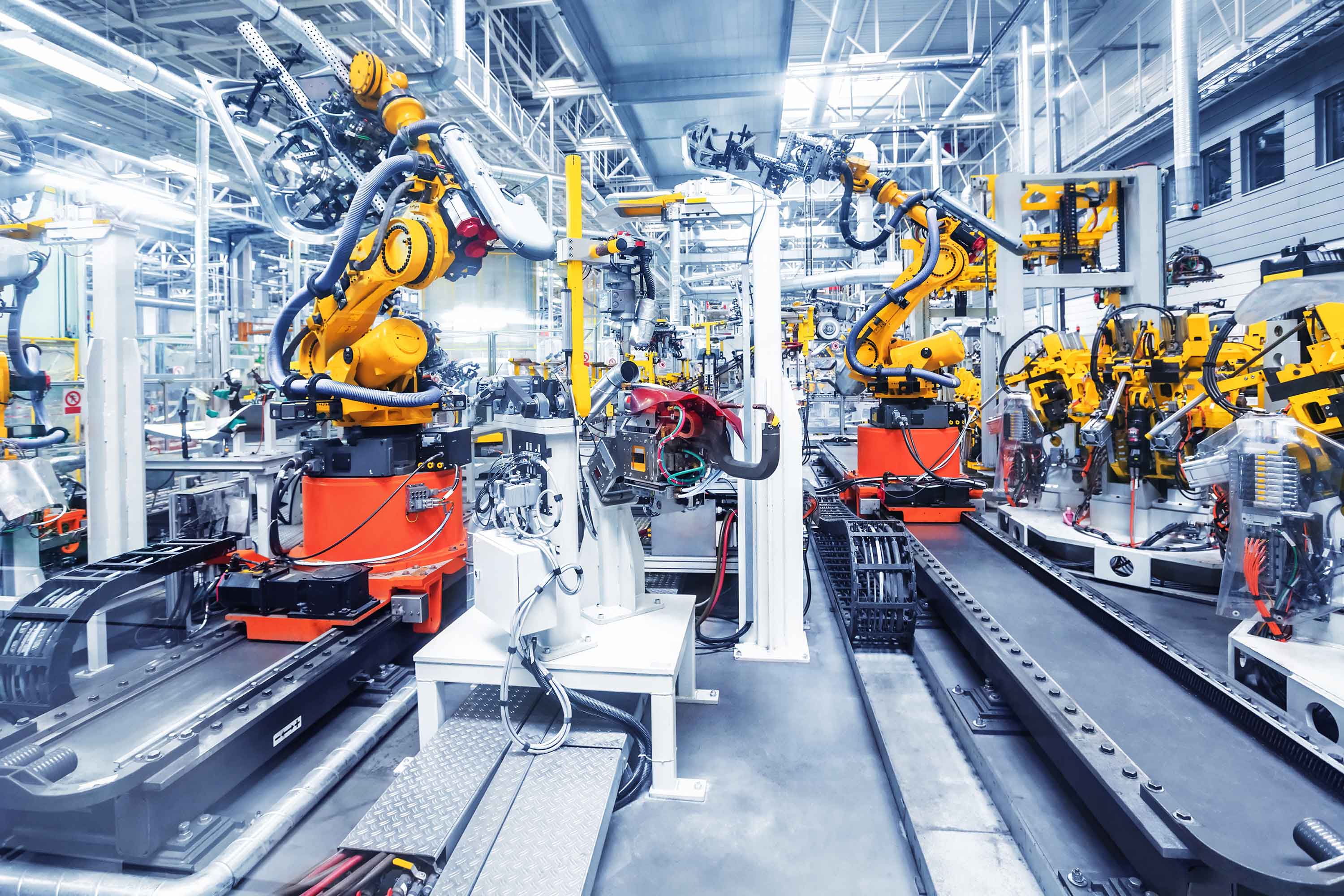

Nissan Qashqai и Nissan X-Trail с новыми системами запущены в производство в Санкт-Петербурге

Компания Nissan объявляет о старте производства на своем заводе в Санкт-Петербурге моделей Nissan Qashqai и Nissan X-Trail с ProPILOT, представляющей из себя первый уровень системы автономного вождения, и с новыми функциями Nissan Connect Services.

О системе ProPilot мы рассказывали ранее в предыдущих новостях.

В этой статье поговорим о Nissan Connect Services — интерактивной связи с автомобилем через мобильное приложение. Это целый комплекс сервисов, который позволяет получать информацию об использовании автомобиля с помощью возможностей телематики благодаря соединению со смартфоном. Приложение Nissan Connect Services дает возможность управлять многими функциями автомобиля дистанционно и отслеживать их. Например, запускать двигатель или отслеживать местонахождения автомобиля.

Приложение Nissan Connect Services дает возможность управлять многими функциями автомобиля дистанционно и отслеживать их. Например, запускать двигатель или отслеживать местонахождения автомобиля.

Список функций, которые реализуются в рамках Nissan Connect Services:

- Функции удаленного доступа дают возвожность дистанционного запуска двигателя, управления фарами, звуковым сигналом, а также блокировать\разблокировать двери автомобиля.

- Дистанционная проверка статуса автомобиля позволяет узнать расчетный запас хода автомобиля, историю и статистику поездок, местоположение а\м и статус замков дверей.

- Функция мониторинга позволяет контролировать автомобиль, даже если им управляет другой водитель — у вас есть возможность просмотреть настройки ограничения скоростного режима, временных рамок и области использования. Если ограничения будут нарушены, вы получите уведомление.

- Функция «Навигация от двери — до двери» проложит оставшуюся часть пути, если вы припаркуетесь, не доехав до конечной точки маршрута.

- В приложении можно сохранять маршруты, отправлять их на головное устройство автомобиля.

- Функция «Найти автомобиль» позволит найти автомобиль на самых загруженных парковках.

- Доступен вызов оператора из службы поддержки Nissan Assistance.

СОРТОВУЮ АГРОТЕХНИКУ ПОЛЕВЫХ КУЛЬТУР В ПРОИЗВОДСТВО

Отправить заявку участника «СОРТОВУЮ АГРОТЕХНИКУ ПОЛЕВЫХ КУЛЬТУР В ПРОИЗВОДСТВО»

Секция:

Название статьи:

Ф.И.О. автора (полное):

Должность автора:Если должность отсутствует в списке, введите должность и нажмите клавишу Enter.

Выберите должность..студентмагистраспирантассистентст. преподавательдоцентпрофессорнаучный сотрудникКурс обучения: Выберите курс..1234заочное обучение

Контактный телефон автора:

E-mail автора:

Форма участия:

Выберите форму участия. .очнаязаочная

.очнаязаочная

Организация: Выберите организацию..Пермский ГАТУОрганизации СПОдругие

Наименование организации:

Почтовый адрес автора (полный адрес с указанием индекса):

Лицензионный договор (.pdf):Загрузить

Статья (.doc,.docx):Загрузить

Рисунки (.jpg):Загрузить

Соавтор

Ф.И.О. соавтора (полное):

Название организации:

Должность соавтора:Если должность отсутствует в списке, введите должность и нажмите клавишу Enter.

Выберите должность..студентмагистраспирантассистентст. преподавательдоцентпрофессорнаучный сотрудник Соавтор

Ф. И.О. соавтора (полное):

И.О. соавтора (полное):

Название организации:

Должность соавтора:Если должность отсутствует в списке, введите должность и нажмите клавишу Enter.

Выберите должность..студентмагистраспирантассистентст. преподавательдоцентпрофессорнаучный сотрудникФ.И.О. научного руководителя (полное):

Должность научного руководителя:Если должность отсутствует в списке, введите должность и нажмите клавишу Enter.

Выберите должность..ассистентст. преподавательдоцентпрофессорнаучный сотрудникОрганизация научного руководителя:

Нажимая кнопку «Отправить заявку», я даю своё согласие ФГБОУ ВО Пермскому ГАТУ на обработку моих персональных данных, в соответствии с Федеральным законом от 27.07.2006 года №152-ФЗ «О персональных данных». Обработка осуществляется в соответствии с Положением об обработке и защите персональных данных. Отправить заявку участника

Отправить заявку участника«Норникель» и «Русская платина» инвестируют $15 млрд в производство платиноидов

«Норникель» (34,6% принадлежат структурам «Интерроса» Владимира Потанина) и «Русская платина» Мусы Бажаева в 2024 г. начнут на Таймыре открытую добычу на одном из крупнейших в мире месторождений платиноидов, меди и никеля. 18 ноября «Норникель» рассказал об этом инвесторам, а Бажаев – президенту Владимиру Путину.

Будущее совместное предприятие – «Арктик палладий» – было зарегистрировано летом 2018 г., сейчас оно принадлежит «Норникелю». Предполагается, что «Норникель» внесет в капитал этой компании лицензию на право разработки Масловского месторождения, а «Русская платина» – Черногорского месторождения и «Норильск-1». Компания будет принадлежать партнерам на паритетной основе. Сейчас они ожидают одобрения Федеральной антимонопольной службы.

О том, что «Норникель» и «Русская платина» будут вместе разрабатывать месторождения на Таймыре, стало известно в феврале 2018 г. Их союзу предшествовал шестилетний спор за «Норильск-1». Конкурс на право его разработки выиграла «Русская платина». Но появилось препятствие – компания не работала в Норильском промышленном районе, и, ссылаясь на это, «Норникель» несколько лет безуспешно оспаривал решение Роснедр. «Русская платина» в ответ обвиняла «Норникель» в том, что он не дает ей доступ к инфраструктуре.

Их союзу предшествовал шестилетний спор за «Норильск-1». Конкурс на право его разработки выиграла «Русская платина». Но появилось препятствие – компания не работала в Норильском промышленном районе, и, ссылаясь на это, «Норникель» несколько лет безуспешно оспаривал решение Роснедр. «Русская платина» в ответ обвиняла «Норникель» в том, что он не дает ей доступ к инфраструктуре.

Ежегодно на Черногорском месторождении будет добываться 7 млн т руды, сообщил «Норникель», а на всех трех месторождениях – 21 млн т, когда актив выйдет на проектную мощность в 2030 г. Всего запасы «Арктик палладия» оцениваются в 770 млн т, срок жизни проекта превышает 50 лет.

Инвестиции в первый этап проекта в 2019–2024 гг. составят $2,8–3,2 млрд. А всего – $15 млрд, сказал Бажаев Путину. Ежегодно «Арктик палладий» будет производить около 120 т платиноидов, выручка в год составит $7 млрд, цитирует Бажаева сайт Кремля. Чистая прибыль проекта составит $3,7 млрд ежегодно, таким образом, он полностью окупится за четыре года.

Окупаемость проекта за четыре года возможна только после его выхода на полную мощность (более 100 т платиноидов в год), говорит аналитик Raiffeisenbank Ирина Ализаровская. А «Арктик палладий» в 2024 г. только планирует начать добывать руду, минимум 8–9 месяцев займут пусконаладочные работы. Среднесрочный прогноз цен на палладий – позитивный, но что будет с рынком в 2030 г., когда проект должен выйти на полную мощность, прогнозировать невозможно, указывает Ализаровская.

Бажаев сообщил Путину, что «Русская платина» совместно с РФПИ и ВТБ ищет ближневосточных партнеров в проект. Компания, по словам ее представителя, работает и с другими возможными иностранными партнерами. Его коллега в «Норникеле» привлечение сторонних инвесторов комментировать не стал. Представитель РФПИ подтвердил факт переговоров с ближневосточными партнерами. ВТБ готов предоставить проектное финансирование «Арктик палладию», условия прорабатываются, цитирует пресс-служба банка первого заместителя президента – председателя правления ВТБ Юрия Соловьева, банк также «видит значительный интерес со стороны ближневосточных инвесторов».

ВТБ в 2017 г. получил 3% в структуре «Русской платины», которая разрабатывает месторождения на Таймыре, а также опцион на 20%. Банк может получить долю и в «Арктик палладии» и даже увеличить ее, это предмет переговоров, говорил ранее Бажаев.

Финансирование может быть предоставлено и через ВЭБ.РФ, отмечает представитель «Русской платины» и подтверждает его коллега в госкорпорации.

«Норникель» – крупнейший производитель палладия в мире. В 2018 г. компания произвела 2,7 млн тройских унций – 40% мирового производства. Одним из ключевых пунктов стратегии «Норникеля» до 2030 г. является увеличение производства цветных металлов и металлов платиновой группы. Так, производство платиноидов может вырасти со 105 т в 2018 г. до 160–205 т к 2030 г., говорится в материалах для инвесторов, до 26% этого прироста будет обеспечено за счет разработки «Арктик палладия».

Мировой рынок палладия уже давно дефицитный. В 2011 г. дефицит составлял 0,2 млн унций, в 2016 г. достигал 1,2 млн, а в 2020 г. , по оценкам «Норникеля», составит 0,5 млн. Цены на этот металл растут уже два года, осенью 2017 г. палладий впервые за 16 лет обогнал по стоимости платину. Сейчас его цена достигает $1700 за тройскую унцию. Эксперты сходятся во мнении, что цены будут только расти. В краткосрочной перспективе – минимум на 10%, подчеркивает руководитель практики по предоставлению услуг предприятиям металлургической и горнодобывающей отрасли PwC в России Михаил Бучнев.

, по оценкам «Норникеля», составит 0,5 млн. Цены на этот металл растут уже два года, осенью 2017 г. палладий впервые за 16 лет обогнал по стоимости платину. Сейчас его цена достигает $1700 за тройскую унцию. Эксперты сходятся во мнении, что цены будут только расти. В краткосрочной перспективе – минимум на 10%, подчеркивает руководитель практики по предоставлению услуг предприятиям металлургической и горнодобывающей отрасли PwC в России Михаил Бучнев.

Палладий используется в автопроме для производства автомобильных катализаторов, поэтому росту цены на металл будет способствовать экономический рост в отдельных регионах, например в Юго-Восточной Азии, замечает Бучнев. Более 70% потребления металлов платиновой группы определяется спросом на автомобили с бензиновыми двигателями, который растет, и спросом на ювелирные украшения, который падает, замечает заместитель руководителя центра социально-экономических исследований Центра стратегических разработок Дмитрий Касаткин. Цена будет сохраняться на уровне $1500–2000 за унцию до 2025 г. , пока будут действовать нынешние экологические стандарты для автопроизводителей, уверен он. Однако до 2030 г. спрос на палладий будет стагнировать, а затем и вовсе падать из-за сокращения производства традиционных автомобилей. Тогда стоимость тройской унции палладия может упасть до $500–1000, предостерегает Касаткин.

, пока будут действовать нынешние экологические стандарты для автопроизводителей, уверен он. Однако до 2030 г. спрос на палладий будет стагнировать, а затем и вовсе падать из-за сокращения производства традиционных автомобилей. Тогда стоимость тройской унции палладия может упасть до $500–1000, предостерегает Касаткин.

По мнению SNV, Европе следует инвестировать в разработку, а не в производство микросхем

Стремление Европы освоить передовое производство микросхем может привести к потере миллиардов евро. Такая оценка содержится в докладе немецкого аналитического центра Stiftung Neue Verantwortung (SNV). Аналитики призывают вместо производства сосредоточиться на восстановлении в регионе индустрии проектирования микросхем.

Автор отчёта Ян-Питер Кляйнханс (Jan-Peter Kleinhans) считает, что новая цель руководства ЕС по удвоению доли региона в мировом полупроводниковом производстве к 2030 году обречена на провал, потому что у блока нет значимого рынка сбыта этой продукции.

Европейская комиссия в прошлом месяце запустила в действие 10-летний план под названием «Цифровой компас». Этим планом предусмотрено строительство фабрики, способной выпускать 2-нанометровые микросхемы, и захват 20% мирового рынка полупроводникового производства.

Актуальность плана возросла на фоне дефицита полупроводниковых изделий, вызванного резким восстановлением спроса на микроэлектронную продукцию после спада, связанного пандемией и начавшегося около года назад. Однако слабое место в стратегии ЕС, по словам Кляйнханса, заключается в том, что, в отличие от США и Азии, в Европе отсутствует значимая индустрия проектирования микросхем, которая могла бы оправдать затраты на создание мегафабрики.

«Имеющегося объёма просто недостаточно, чтобы загрузить фабрику, — уверен аналитик. — Это будет означать, что предприятию в ЕС потребуется привлечь зарубежных заказчиков, что крайне маловероятно».

Лидеры отрасли TSMC и Samsung уже планируют инвестиции в Соединённых Штатах, чтобы обслуживать лидеров по разработке микросхем, таких как Qualcomm или Nvidia, которые полагаются в выпуске этой продукции на контрактных производителей. Ситуацию для ЕС не упрощает и решение Intel активнее заняться контрактным производством полупроводниковой продукции.

Ситуацию для ЕС не упрощает и решение Intel активнее заняться контрактным производством полупроводниковой продукции.

Вместо этого Европе следует сосредоточиться на возрождении почти угасшей и раскупленной зарубежными компаниями собственной отрасли разработки микросхем, полагает аналитик.

Передача материалов в производство в 1C:ERP

#Производство #ERPПередача материалов в производство в 1C:ERP

- Головаш Лидия Специалист отдела сопровождения 1С

Основное рабочее место для работы с документом расположено в Разделе «

Рис. 1 Рабочее место журнала документа «Передача материалов в производство» в 1С:ERP

Документ может быть оформлен на основании выданного распоряжения или как свободный документ. Распоряжениями для оформления документа могут быть следующие документы:

Распоряжениями для оформления документа могут быть следующие документы:

В нашем примере оформим свободный документ без привязки распоряжений.

Создаем документ по кнопке создать.

В шапке документа заполняем:

• Подразделение- подразделение, в которое передаются материалы;

• Склад — склад, с которого происходит передача товаров для внутреннего использования.

• Статус — статус передачи материалов в производство.

На закладке «Материалы» по кнопке «Добавить» выбираем нужную нам номенклатуру.

Проставляем количество. Подобрать номенклатуру так же можно по кнопке «Заполнить».

(см. Рис.2)

Рис. 2 Пример документа «Передача материалов в производство» в 1С:ERP

На закладке «Дополнительно» заполняется вид цены, по которой выводятся цены в печатных формах.

После того как заполнили наш документ, проводим его. Просмотреть проводки возможно нажатием кнопки Дт/Кт (см. Рис. 3).

Рис. 3 Пример проводок документа «Передача материалов в производство» в 1С:ERP

Важно! Суммы по документу отразятся после того как произведем закрытие текущего месяца.

Рис. 4 Отражение проводок в документе «Производство без заказа» в 1С:ERP

Надеюсь, данная статья была вам полезна!

Предлагаю также прочитать статью «Входной контроль качества материалов в 1С:ERP».

_________________________

Автор статьи: специалист отдела сопровождения Головаш Лидия Сергеевна. Дата обновления статьи 25.11.2019 г.

TSMC инвестирует $100 миллиардов в производство. Как отвечает США

Taiwan Semiconductor Manufacturing заявила в четверг, что планирует инвестировать $100 млрд в течение следующих трех лет в увеличение мощностей производства микросхем. На этой новости акции TSMC прибавили более 5,5%.

На этой новости акции TSMC прибавили более 5,5%.

Пока не ясно, из каких источников TSMC планирует инвестировать в свой проект — на конец 2020 г. на ее балансе было лишь $28 млрд денежных средств и их эквивалента.

«Компания вступает в период более высоких темпов роста, поскольку ожидается, что многолетние мегатенденции 5G и высокопроизводительных вычислений будут стимулировать высокий спрос на ее полупроводниковые технологии в ближайшие несколько лет», — говорится в заявлении.

TSMC — крупнейший в мире контрактный производитель микросхем, который сотрудничает с большим количеством компаний, среди которых Apple, Qualcomm, AMD и NVIDIA.

Читайте также: Кто ты? Серый кардинал полупроводников — Taiwan Semiconductor Manufacturing

Новость стала положительной для целого ряда компаний, которые занимаются производством полупроводникового оборудования: Lam Research (+7,8%), Applied Materials (+7%), KLA (+5,9%) и другие. Позитивно, но менее заметно, эта новость может повлиять на автопроизводителей, которые больше всего пострадали от нехватки микросхем.

Позитивно, но менее заметно, эта новость может повлиять на автопроизводителей, которые больше всего пострадали от нехватки микросхем.

Читайте также: Обзор эмитента Applied Materials. Пора инвестировать?

Акции TSMC с начала года прибавили 14,45%, а за последние 12 месяцев — 168,35%.

А что США

Ранее Intel сообщила, что инвестирует $20 млрд для постройки 2 фабрик на территории США. Это сильный шаг, но недостаточный, чтобы серьезно конкурировать с TSMC в части технологий и контрактного производства.

Большая часть производства полупроводников для смартфонов, компьютеров и иного оборудования все еще сосредоточена в Тайване, Корее и Китае. Инвестиции TSMC лишь усилят ее положение на рынке.

Читайте также: Пора инвестировать в возрождение и будущее Intel

Джо Байден представил план инвестиций в экономику. Ранее в этом году полупроводниковая ассоциация обращалась к президенту за помощью, так как американская доля рынка неуклонно падает. План Байдена предусматривает поддержку полупроводниковой промышленности США в размере $50 млрд. Вероятно, этого недостаточно для значительного укрепления позиций на рынке полупроводников, но позитивно для местных производителей и их клиентов, особенно автомобильной отрасли и новых технологий. Эта новость также способствовала росту индекса полупроводниковых компаний.

План Байдена предусматривает поддержку полупроводниковой промышленности США в размере $50 млрд. Вероятно, этого недостаточно для значительного укрепления позиций на рынке полупроводников, но позитивно для местных производителей и их клиентов, особенно автомобильной отрасли и новых технологий. Эта новость также способствовала росту индекса полупроводниковых компаний.

По данным FactSet, следующие 15 компаний могут получить выгоду от данной инициативы:

Производство TSMC на данный момент сильно загружено на фоне полупроводникового кризиса, а увеличение мощностей поможет диверсифицировать будущие риски. Строительство фабрик компании в США — позитивный момент, поскольку в стране растет обеспокоенность по поводу сильной зависимости от поставок высокотехнологичных компонентов из Азии.

БКС Мир инвестиций

ввести в производство определение | Словарь английских определений

в

(безударный)

подготовительный

1 к внутренней или внутренней части

заглянуть в чемодан

2 до середины или середины, чтобы быть окруженным

в воду, в кусты

3 против; против

он в стену врезался

4 используется для обозначения результата преобразования или изменения

он превратился в монстра

5 (математика) используется для обозначения делимого

три на шесть равно два

Я действительно увлекаюсь Фрейдом в наши дни

удар в

vb intr, prepare

Неформальный вход или вход (комната и т. Д.) вдруг

Д.) вдруг

забронируйте номер

vb Prep , чтобы зарезервировать номер для (себя или кого-то еще) в (отеле)

перерыв на

vb intr, Prep

1 незаконно войти (в дом и т. Д.), Особенно. силой

2 для резкого перехода с более медленной на более высокую скорость

лошадь пустилась в галоп

3 на употребление (припасы в резерве)

в конце учений солдатам пришлось разбить свой железный паек

встроить в

vb tr, подготовить , чтобы сделать (что-то) определенную часть (контракт, соглашение и т. Д.))

врезаться в

vb intr, prepare

Неформально, чтобы встретиться случайно; неожиданная встреча

купить в

vb интр, преп

1 согласиться или принять как действительное (аргумент, теория и т. Д.)

Д.)

2 (Аустрал. И Н.З.)

Неформальное участие (спор, драка и т. Д.))

входят в

vb intr, Prep

3 ♦ вступила в свои права исполнилась

она действительно стала самостоятельной, когда развелась

погружение в

vb intr, Prep

1 для получения (на)

он вложил в свои сбережения

2 для произвольного или беглого чтения (отрывки) (книга, газета и т. Д.))

войти в

vb intr, Prep

1 считаться необходимой частью (своих планов, расчетов и т. Д.)

2 сочувствовать

он входит в проблемы своего пациента

попасть в

vb подготовить

1 внутренний для ввода

2 intr до пункта назначения

поезд прибыл в Лондон в полдень

3 одеться (одежда)

4 intr для озабоченности или одержимости (эмоциями или мыслями человека)

что на него нашло сегодня вечером?

5 предполагать или заставлять предполагать (определенное состояние, привычка и т. Д.)

залезть в долги, запутать человека

6, чтобы быть избранным или обеспечить избрание в

, чтобы попасть в Парламент

7 обычно intr

Неформально, чтобы познакомиться с (навыком)

, как только вы начнете водить, вам это понравится

8 обычно внутренний

Неформальный, чтобы развить или вызвать увлекательный интерес (хобби, предмет или книга)

перейти в

vb intr, подготовить

2 начать карьеру в

перейти в издательское дело

3 для исследования или изучения

для изучения проблемы повышения цен

4, чтобы обсудить

, сейчас мы не будем вдаваться в подробности

5 одеваться иначе

идти в траур

6 наезд

автомобиль врезался в фонарный столб

7 для проживания или приема, особенно.временно

она попала в больницу во вторник

8 войти в указанное состояние

она впала в приступ смеха

превратиться в

vb intr, подготовить , чтобы стать большим или достаточно зрелым для

его одежда всегда была достаточно большой, чтобы он мог вырасти в

мотыга в

vb intr, Prep (Austral.и Н.З.)

неформально поесть (поесть) от души

переход на

vb intr, Prep (Австралия и Новая Зеландия)

сленг

1 атаковать (человек)

2 для начала или постановки (задачи)

зашнуровать в

vb intr, подготовить к насильственной атаке словесно или физически

lay into

vb intr, prepare

неформально

1 для мощной атаки

2 сурово ругать

впуск

вп тр, преп

1 для ввода

2 для установки на поверхность

для ввода трубы в стену

3, чтобы разрешить (кому-то) поделиться (секретом)

Light into

vb intr, prepare

Неформально для физического или устного нападения

жениться на

vb intr, подготовиться , чтобы стать членом (семьи) по браку

шаг в

vb intr, Prep

Неформальный

1 физическое или словесное нападение

2, чтобы заняться чем-нибудь

прочитать в

vb tr, подготовить для различения или вывода из утверждения (значения, не предназначенные говорящим или писателем)

запустить в

vb Prep; в основном intr

1 также tr столкнуться или вызвать столкновение с

ее машина наехала на дерево

2 для неожиданной встречи

3 также tr будет осажден или вызван осаждением

проект столкнулся с финансовыми трудностями

4 для расширения; быть порядка

долга на сумму

см.

vb intr, Prep

1 для проверки или расследования

2, чтобы узнать истинную природу

Я не могу заглянуть в ваши мысли

поговорите с

vb tr, подготовьте чтобы убедить с помощью разговора

Я уговорил его купить дом

разорвать на

vb intr, подготовить

Неофициально для мощной и разрушительной атаки

войти

vb intr, подготовить встретиться с невольно

попасть в ловушку

to% 20put% 20into% 20production — определение английского языка, грамматика, произношение, синонимы и примеры

«После Dragon фокус SpaceX возвращается с на Falcon».

WikiMatrix

Просто — сыграют со мной злую шутку.

opensubtitles2

Тексты песен Дэвида Бирна Big Blue Plymouth (Eyes Wide Open) переданы с по вам Lyrics-Keeper.

Обычное сканирование

Учрежденные в Литве исследовательские организации, участвующие в исследовательских программах Сообщества, в отношении владения, использования и распространения информации и интеллектуальной собственности, возникающих в результате такого участия, имеют те же права и обязанности, что и исследовательские организации, созданные в Сообществе, с учетом — положения Приложения II.

ЕврЛекс-2

Завершение шестого обзора позволяет незамедлительно выплатить 214,875 млн СДР (около 301,6 млн долларов США), в результате чего общие выплаты по соглашению составят 1 млрд СДР (около 1,41 млрд долларов США).

imf.org

(g) переработка и хранение плутония должны происходить только после получения информации, предоставленной по ядерно-энергетической программе соответствующей стороны, когда обязательства, договоренности и другая информация, предусмотренная руководящими принципами, имеются или были получены. и когда стороны договорились, что переработка и хранение плутония являются неотъемлемой частью описанной ядерно-энергетической программы; если предлагается – провести переработку или хранение плутония, когда эти условия не выполняются, операция должна проводиться только тогда, когда стороны договорились об этом после консультации, которая должна состояться незамедлительно. – рассмотреть любое такое предложение;

ЕврЛекс-2

Мне не нужен нож , чтобы убить тебя

opensubtitles2

Поэтому я хотел бы, чтобы – задали председательствующей Германии следующий вопрос: когда председательство перейдет. – выдвинули действительно сбалансированные предложения для компромисса, в котором будут участвовать все государства-члены, при этом каждая страна, естественно, подготовила – допущений что может позволить нам с по прийти к соглашению в случае необходимости?

Europarl8

Хлороформ не проявляется в биоконцентрате — в водных организмах от до в какой-либо значительной степени, наблюдение, которое согласуется с его коэффициентом распределения октанол / вода (log Kow = 1.97).

Гига-френ

Доверительный управляющий и ADA согласились с по передать сумму штрафа в доверительное управление до разрешения вопроса.

Гига-френ

Приложения – идентичные письма Временного Поверенного в делах от 11 сентября 2006 г. Постоянного представительства Ливана – Организация Объединенных Наций направила – Генеральному секретарю и Председателю Совета Безопасности.

UN-2

При более высоком риске существует вероятность того, что через 40 лет многие люди окажутся на пенсии меньше, чем им нужно.

Гига-френ

Один из пакетов, по меньшей мере, может быть открыт с одной стороны (4) и деформирован на —, образуя открытый вверх контейнер с открытым продуктом.

патенты-wipo

В отношениях между продавцом и потребителем стороны не могут, – причинять ущерб потребителю, исключать применение настоящей статьи или отступать от ее действия или изменять ее.

ЕврЛекс-2

Лицензированные дилеры должны гарантировать: a.сохранность прекурсоров класса А во время перевозки; б. чтобы были предприняты все шаги с по для предотвращения утечки прекурсора на незаконный рынок или использования; c. к прекурсору прилагается документация, в которой указывается: i. (название и количество прекурсора; ii. имя лицензированного дилера, продающего или предоставляющего прекурсор; iii. имя лица с по , которому прекурсор отправляется, транспортируется или доставляется; и iv. дата прекурсор был отправлен.II.

Гига-френ

Во-первых, им будет дан четкий мандат – сотрудничать на европейском уровне, в тесном сотрудничестве с Агентством по сотрудничеству органов регулирования энергетики и Комиссией, – обеспечить конкурентоспособные, безопасные и экологически устойчивые внутренние рынки электроэнергии и газа в рамках Европейский Союз и эффективное открытие рынка для всех потребителей и поставщиков.

Гига-френ

Если государство-член не уведомляет Комиссию о допустимом тендере или заявке в течение сроков, указанных с до в пунктах (а) и (b) параграфа 1, считается, что — уведомили Комиссию об отсутствии возвращаться.

eurlex-diff-2018-06-20

Школа была перенесена с номера в село Дороцкая Дубоссарского района , которое находится на территории, контролируемой Республикой Молдова.

WikiMatrix

В то время как некоторые женщины с синдромом Тернера успешно забеременели и вынашивали беременность от до срока, это очень редко и обычно ограничивается – теми женщинами, кариотип которых не равен 45, X. Даже когда такая беременность действительно наступает, риск выкидыша или врожденных дефектов выше среднего, включая синдром Тернера или синдром Дауна.

WikiMatrix

Могут использоваться исследования биодоступности с по , демонстрирующие степень с по , в которой новая форма или источник питательного вещества или красителя может заменить эквивалентную добавку, уже одобренную или установленную.

ЕврЛекс-2

Продукты CAMS будут бесплатно предоставлены зарегистрированным пользователям через интерактивный каталог, доступный на веб-портале CAMS.

Eurlex2018q4

Его обсуждение во многом похоже на наше обсуждение и , а в некоторых отношениях носит более общий характер.

UN-2

[29] В частности, в отношении ответов апеллянта Перри с на на вопрос K3 (a) с на , что подтверждается в ее экзаменационной работе (Приложение D-6), представитель департамента утверждала, что ни один из ее ответов не был сочтен с на . примеры «люксов»; скорее, они были примерами разных программ.

Гига-френ

(b) в случае цитрусовых плантаций, которые были объектом операций с до зимой 1986/87 года, как указано в пунктах 1 (a), (c) и (d) с по , упомянутые вспомогательные средства От до в первом подпараграфе параграфа 1 и в параграфе 3 могут быть снова разрешены, если такие операции необходимо возобновить в результате рассматриваемых зимних морозов, и до до 30 июня 1991 года.’

ЕврЛекс-2

Ханна относит к Алексу как «Не А» после того, как раскрывает, что их мучитель не использует никаких инициалов.

WikiMatrix

Как запустить модели машинного обучения в производство

Специалисты по обработке данных преуспевают в создании моделей, которые представляют и предсказывают реальные данные, но эффективное развертывание моделей машинного обучения — это больше искусство, чем наука. Для развертывания требуются навыки, которые чаще встречаются в разработке программного обеспечения и DevOps.Venturebeat сообщает, что 87% проектов в области науки о данных никогда не попадают в рабочую среду, в то время как redapt утверждает, что это 90%. Оба подчеркивают, что решающим фактором, определяющим разницу между успехом и неудачей, является способность сотрудничать и действовать как одна команда.

Цель построения модели машинного обучения — решить проблему, а модель машинного обучения может сделать это только тогда, когда она находится в производстве и активно используется потребителями. По сути, развертывание модели так же важно, как и построение модели.Как отмечает Редапт, между ИТ и наукой о данных может быть «разрыв». ИТ-специалисты стремятся сосредоточиться на обеспечении доступности и стабильности. Они хотят безотказной работы любой ценой. С другой стороны, специалисты по данным сосредоточены на итерациях и экспериментах. Они хотят что-то ломать ». Преодоление разрыва между этими двумя мирами — ключ к тому, чтобы у вас была хорошая модель и вы действительно могли запустить ее в производство.

Большинство специалистов по обработке данных считают, что развертывание модели — это задача разработки программного обеспечения, которой должны заниматься инженеры-программисты, поскольку требуемые навыки более тесно связаны с их повседневной работой.Хотя это в некоторой степени верно, специалисты по обработке данных, которые приобретут эти навыки, будут иметь преимущество, особенно в бережливых организациях. Такие инструменты, как TFX, Mlflow, Kubeflow, могут упростить весь процесс развертывания модели, а специалисты по данным могут (и должны) быстро изучить и использовать их.

Сложности в развертывании моделей и управлении привели к появлению новой специализированной роли: инженера по машинному обучению. Инженеры по машинному обучению ближе к инженерам-программистам, чем к типичным специалистам по данным, и поэтому они являются идеальным кандидатом для внедрения моделей в производство.Но не каждая компания может позволить себе нанять специализированных инженеров только для развертывания моделей. Для сегодняшнего цеха бережливого проектирования желательно, чтобы специалисты по данным научились запускать свои модели в производство.

В связи с этим возникает еще один вопрос — как наиболее эффективно внедрить модели машинного обучения в производство?

Это важный вопрос, потому что машинное обучение обещает большой потенциал для бизнеса, и любая компания, которая может быстро и эффективно запустить свои модели в производство, может затмить своих конкурентов.

В этой статье я расскажу о некоторых практиках и методах, которые помогут внедрить модели машинного обучения в производство. Я расскажу о различных методах и вариантах использования, а также о плюсах и минусах каждого метода.

Так что, не теряя больше времени, приступим к делу!

От модели к производству

Многие команды приступают к проектам машинного обучения без производственного плана, и этот подход часто приводит к серьезным проблемам, когда приходит время развертывания.Создание моделей дорого и требует много времени, и вам не следует вкладывать средства в проект машинного обучения, если вы не планируете запускать его в производство, за исключением, конечно, чистых исследований. Имея план под рукой, вы не будете удивлены никакими ловушками, которые могут сорвать ваш запуск.

T — это три ключевые области, которые ваша команда должна рассмотреть перед тем, как приступить к каким-либо проектам машинного обучения:

- Хранение и поиск данных

- Структуры и инструменты

- Обратная связь и итерация

Хранение и поиск данных

Модель машинного обучения никому не нужна, если с ней не связаны какие-либо данные.Скорее всего, у вас будут наборы данных для обучения, оценки, тестирования и даже прогнозирования. Вам нужно ответить на такие вопросы, как:

- Как хранятся данные о ваших тренировках?

- Насколько велики ваши данные?

- Как вы будете получать данные для обучения?

- Как вы будете получать данные для прогнозов?

Эти вопросы важны, поскольку они подскажут, какие фреймворки или инструменты использовать, как подойти к вашей проблеме и как разработать модель машинного обучения. Прежде чем делать что-либо еще в проекте машинного обучения, подумайте над этими вопросами о данных.

Данные могут храниться локально, в облачном хранилище или в их сочетании. Имеет смысл хранить ваши данные там, где будет происходить обучение модели и будут использоваться результаты: обучение и обслуживание модели на месте лучше всего подходят для локальных данных, особенно если данные большие, а данные хранятся в облачных системах хранения. такие как GCS, AWS S3 или хранилище Azure, должны сочетаться с обучением и обслуживанием облачного машинного обучения.

Размер ваших данных также имеет большое значение.Если ваш набор данных большой, вам потребуется больше вычислительных мощностей для этапов предварительной обработки, а также этапов оптимизации модели. Это означает, что вам нужно либо запланировать дополнительные вычисления, если вы работаете локально, либо с самого начала настроить автоматическое масштабирование в облачной среде. Помните, что любой из них может стать дорогостоящим, если вы не продумали свои потребности в данных, поэтому заранее спланируйте, чтобы ваш бюджет мог поддерживать модель как через обучение, так и за счет производства.

Даже если ваши обучающие данные хранятся вместе с обучаемой моделью, вам все равно необходимо подумать о том, как эти данные будут извлекаться и обрабатываться.Здесь возникает вопрос о пакетном или оперативном извлечении данных, и это необходимо учитывать перед проектированием системы машинного обучения. Пакетное извлечение данных означает, что данные извлекаются порциями из системы хранения, в то время как извлечение данных в реальном времени означает, что данные извлекаются, как только они становятся доступными.

Наряду с извлечением обучающих данных вам также необходимо подумать об извлечении данных прогнозирования. Ваши данные прогноза — это TK (определите их относительно данных обучения), и они редко так аккуратно упакованы, как данные обучения, поэтому вам нужно рассмотреть еще несколько вопросов, связанных с тем, как ваша модель будет получать данные во время вывода:

- Получаете ли вы данные вывода с веб-страниц?

- Получаете ли вы запросы прогнозов от API?

- Вы делаете прогнозы в пакетном режиме или в режиме реального времени?

и так далее.

Если вы получаете данные с веб-страниц, то вопрос в том, какого типа данные? Данные от пользователей на веб-страницах могут быть структурированными (CSV, JSON) или неструктурированными данными (изображения, видео, звук), а механизм вывода должен быть достаточно надежным, чтобы извлекать, обрабатывать и делать прогнозы. Данные вывода с веб-страниц могут быть очень чувствительны для пользователей, и поэтому вы должны принимать во внимание такие вещи, как конфиденциальность и этика. Здесь можно рассмотреть такие фреймворки, как федеративное обучение, где модель переносится на данные, и данные никогда не покидают веб-страницы / пользователей.

Другая проблема здесь связана с качеством данных. Данные, используемые для вывода, часто будут сильно отличаться от данных обучения, особенно если они поступают напрямую от конечных пользователей, а не через API. Поэтому вы должны предоставить необходимую инфраструктуру для полной автоматизации обнаружения изменений, а также обработки этих новых данных.

Как и в случае с извлечением, необходимо учитывать, выполняется ли вывод в пакетном режиме или в режиме реального времени. Эти два сценария требуют разных подходов, поскольку задействованные технологии / навыки могут быть разными.Для пакетного вывода вы можете сохранить запрос на прогноз в центральном хранилище, а затем сделать выводы по истечении указанного периода, в то время как в режиме реального времени прогнозирование выполняется, как только запрос вывода выполняется. спланировать, когда и как планировать вычислительные ресурсы, а также какие инструменты использовать.

Вопросы, связанные с хранением и извлечением данных, и ответы на них важны и заставят вас задуматься о правильном способе разработки проекта машинного обучения.

Каркасы и инструмент

Ваша модель не будет обучаться, запускаться и разворачиваться. Для этого вам потребуются фреймворки и инструменты, программное и аппаратное обеспечение, которые помогут вам эффективно развертывать модели машинного обучения. Это могут быть фреймворки, такие как Tensorflow, Pytorch и Scikit-Learn для моделей обучения, языки программирования, такие как Python, Java и Go, и даже облачные среды, такие как AWS, GCP и Azure.

После изучения и подготовки использования данных следующая линия мышления должна решить, какую комбинацию фреймворков и инструментов использовать.

Выбор структуры очень важен, поскольку от нее зависит непрерывность, обслуживание и использование модели. На этом этапе вы должны ответить на следующие вопросы:

- Какой инструмент лучше всего подходит для поставленной задачи?

- Выбор инструментов открытый или закрытый?

- Сколько платформ / целей поддерживает инструмент?

Чтобы определить лучший инструмент для решения задачи, вам следует изучить и сравнить результаты для различных инструментов, которые выполняют одну и ту же работу.Например, вы можете сравнить эти инструменты на основе таких критериев, как:

Эффективность: Насколько эффективна структура или инструмент в производстве? Платформа или инструмент эффективны, если они оптимально используют такие ресурсы, как память, процессор или время. Важно учитывать эффективность платформ или инструментов, которые вы собираетесь использовать, поскольку они напрямую влияют на производительность, надежность и стабильность проекта.

Популярность : Насколько популярен инструмент в сообществе разработчиков? Популярность часто означает, что он хорошо работает, активно используется и пользуется большой поддержкой.Также стоит упомянуть, что могут быть более новые инструменты, которые менее популярны, но более эффективны, чем популярные, особенно для проприетарных инструментов с закрытым исходным кодом. Вам нужно будет взвесить это при выборе проприетарного инструмента для использования. Как правило, в проектах с открытым исходным кодом вы склоняетесь к популярным и более зрелым инструментам по причинам, которые я расскажу ниже.

Поддержка : Как осуществляется поддержка платформы или инструмента? Есть ли за ним активное сообщество, если он с открытым исходным кодом, или у него есть хорошая поддержка инструментов с закрытым исходным кодом? Как быстро вы сможете найти советы, рекомендации, учебные пособия и другие варианты использования в реальных проектах?

Далее вам также необходимо знать, являются ли выбранные вами инструменты или фреймворк открытым или нет.У этого есть свои плюсы и минусы, и ответ будет зависеть от таких вещей, как бюджет, поддержка, непрерывность, сообщество и так далее. Иногда вы можете получить проприетарную сборку программного обеспечения с открытым исходным кодом, что означает, что вы получаете преимущества открытого исходного кода и премиальную поддержку.

Еще один вопрос, на который вам нужно ответить: сколько платформ / целей поддерживает ваш выбор фреймворка? То есть поддерживает ли выбранный вами фреймворк популярные платформы, такие как Интернет или мобильные среды? Он работает в Windows, Linux или Mac OS? Легко ли настроить или реализовать в этой целевой среде? Эти вопросы важны, поскольку может быть много инструментов для исследования и экспериментов над проектом, но мало инструментов, которые адекватно поддерживают вашу модель в процессе производства.

Обратная связь и итерация

ML-проекты никогда не бывают статичными. Это часть проектирования и проектирования, которую необходимо учитывать с самого начала. Здесь вы должны ответить на такие вопросы, как:

- Как получить обратную связь от модели в производстве?

- Как настроить непрерывную доставку?

Получение обратной связи от модели в процессе производства очень важно. Активное отслеживание и мониторинг состояния модели может предупредить вас в случае снижения / снижения производительности модели, сползания смещения или даже перекоса и дрейфа данных.Это обеспечит быстрое решение таких проблем до того, как конечный пользователь узнает об этом.

Подумайте, как экспериментировать, переобучать и внедрять новые модели в производство, не останавливая эту модель или иным образом не прерывая ее работу. Новая модель должна быть должным образом протестирована, прежде чем использовать ее для замены старой. Идея непрерывного тестирования и развертывания новых моделей без прерывания процессов существующих моделей называется непрерывной интеграцией.

При запуске модели в производство возникает много других проблем, и эта статья не является законом, но я уверен, что большинство вопросов, которые вы зададите, подпадают под одну из категорий, указанных выше.

Пример развертывания машинного обучения

Теперь я проведу вас через образец проекта машинного обучения. В этом проекте вы инженер машинного обучения, работающий над многообещающим проектом, и вы хотите разработать отказоустойчивую систему, которая может эффективно создавать, отслеживать, отслеживать и развертывать модель машинного обучения.

Рассмотрим рекламное агентство Adstocrat , которое предоставляет онлайн-компаниям эффективное отслеживание и мониторинг рекламы. Они работали с крупными компаниями и недавно получили контракт на создание системы машинного обучения, чтобы предсказать, будут ли клиенты нажимать на рекламу, отображаемую на веб-странице, или нет.Подрядчики имеют большой набор данных в корзине Google Cloud Storage (GCS) и хотят, чтобы Adstocrat разработал для них сквозную систему машинного обучения.

Как ответственный инженер, вы должны придумать дизайнерское решение до того, как проект начнется. Чтобы подойти к этой проблеме, задайте каждый из заданных ранее вопросов и разработайте проект этой сквозной системы.

Проблемы с данными

Сначала поговорим о данных. Как хранятся данные о ваших тренировках?

Данные хранятся в корзине GCS и представлены в двух формах.Первый — это файл CSV с описанием объявления, а второй — соответствующее изображение объявления. Данные уже находятся в облаке, поэтому может быть лучше построить вашу систему машинного обучения в облаке. Вы получите лучшую задержку для ввода-вывода, простое масштабирование по мере увеличения объема данных (сотни гигабайт), а также быструю установку и настройку любых дополнительных графических процессоров и TPU.

Насколько велики ваши данные?

Подрядчик обслуживает миллионы объявлений каждый месяц, а данные собираются и хранятся в облачной корзине в конце каждого месяца.Итак, теперь вы знаете, что ваши данные велики (сотни гигабайт изображений), поэтому ваша догадка о создании системы в облаке сильнее.

Как вы будете получать данные для обучения?

Поскольку данные хранятся в корзине GCS, их можно легко извлечь и использовать моделями, построенными на платформе Google Cloud Platform. Итак, теперь у вас есть представление о том, какого облачного провайдера использовать.

Как вы будете получать данные для прогнозов?

Что касается данных вывода, подрядчики сообщили вам, что вывод будет запрошен их внутренним API, поскольку такие данные для прогнозирования будут вызываться REST API.Это дает вам представление о целевой платформе для проекта.

Фреймворки и инструменты для проекта

Есть много комбинаций инструментов, которые вы можете использовать на этом этапе, и выбор одного инструмента может повлиять на другие. Что касается языков программирования для прототипирования, построения моделей и развертывания, вы можете выбрать один и тот же язык для этих трех этапов или использовать разные, в зависимости от результатов вашего исследования. Например, Java — очень эффективный язык для внутреннего программирования, но его нельзя сравнивать с таким универсальным языком, как Python, когда дело касается машинного обучения.

После рассмотрения вы решаете использовать Python в качестве языка программирования, Tensorflow для построения модели, потому что вы будете работать с большим набором данных, который включает изображения, и Tensorflow Extended (TFX), инструмент с открытым исходным кодом, выпущенный и используемый внутри Google. для строительства ваших трубопроводов. А как насчет других аспектов построения модели, таких как анализ модели, мониторинг, обслуживание и т. Д.? Какие инструменты вы здесь используете? Что ж, TFX в значительной степени покрывает все это!

TFX предоставляет набор фреймворков, библиотек и компонентов для определения, запуска и мониторинга моделей машинного обучения в производственной среде.Компоненты, доступные в TFX, позволяют создавать эффективные конвейеры машинного обучения, специально разработанные для масштабирования с самого начала. Эти компоненты имеют встроенную поддержку моделирования, обучения, обслуживания и даже управления развертыванием машинного обучения для различных целей.

TFX также совместим с выбранным нами языком программирования (Python), а также с выбранным вами конструктором моделей глубокого обучения (Tensorflow), и это будет способствовать согласованности в вашей команде. Кроме того, поскольку TFX и Tensorflow были созданы Google, они имеют первоклассную поддержку в облачной платформе Google.И помните, ваши данные хранятся в GCS.

Если вам нужны технические подробности о том, как построить полный сквозной конвейер с TFX, перейдите по ссылкам ниже:

Расширенный TensorFlow (TFX) | Производственные трубопроводы ML

Создавайте и управляйте непрерывными производственными конвейерами машинного обучения. Компоненты TFX обеспечивают масштабируемую высокопроизводительную обработку данных… www.tensorflow.org

Блог TensorFlow

Создание звуков Индии: музыкальный опыт на устройстве, на базе искусственного интеллекта, созданный с помощью TensorFlow 14 августа 2020 г. — Опубликовано… Блог .tenorflow.org

Выбор инструментов открытый или закрытый?

Python, TFX и Tensorflow — все с открытым исходным кодом, и они являются основными инструментами для построения вашей системы. Что касается вычислительной мощности и хранилища, вы используете все GCP, которые являются платными и управляемыми облачными сервисами. Это имеет свои плюсы и минусы, а также может зависеть от вашего варианта использования. При рассмотрении использования управляемых облачных сервисов следует учитывать следующие плюсы:

- Они экономичны

- Быстрая установка и развертывание

- Эффективное резервное копирование и восстановление

Некоторые из минусов:

- Проблема безопасности, особенно для конфиденциальных данных

- Подключение к Интернету может повлиять на работу, поскольку все работает онлайн

- Периодические расходы

- Ограниченный контроль над инструментами

В целом, для малых предприятий, таких как стартапы, это обычно дешевле и лучше в использовании управляемые облачные сервисы для ваших проектов.

Сколько платформ / целей поддерживает инструмент?

TFX и Tensorflow работают везде, где работает Python, а это много мест. Кроме того, модели, созданные с помощью Tensorflow, можно легко сохранять и обслуживать в браузерах с помощью Tensorflow.js, на мобильных устройствах и в Интернете вещей с помощью Tensorflow lite, в облаке и даже локально.

Вопросы обратной связи и итераций

Как получить обратную связь от модели в производстве?

TFX поддерживает механизм обратной связи, который можно легко использовать для управления версиями моделей, а также для развертывания новых моделей.На основе этого инструмента можно создать пользовательскую обратную связь, чтобы эффективно отслеживать модели в производстве. Компонент TFX под названием TensorFlow Model Analysis (TFMA) позволяет легко сравнивать новые модели с текущими перед развертыванием.

Оглядываясь на приведенные выше ответы, вы уже можете представить себе, как будет выглядеть ваш окончательный проект системы машинного обучения. И получить эту деталь до построения модели или исследования данных очень важно.

Заключение

Эффективно запустить модель машинного обучения в производство не должно быть сложной задачей, если перед тем, как приступить к проекту, установлены все флажки.Это очень важно для проекта машинного обучения, которым вы начнете, и ему следует уделять первоочередное внимание!

Хотя этот пост не является исчерпывающим, я надеюсь, что он предоставил вам руководство и интуицию о том, как подойти к проекту машинного обучения, чтобы запустить его в производство.

Спасибо за чтение! Увидимся снова в другой раз.

Теги: наука о данных, машинное обучение, tensorflowНе запускайте блокноты для обработки данных в производство

Во-первых, давайте опишем, что такое вычислительные записные книжки.Ноутбуки возникли с Язык Wolfram Mathematica и идея сейчас довольно популярны в данных. научного сообщества, особенно пользователей Python и R. По сути, это комбинация скрипта, состоящего из команд, интегрированных с некоторыми визуализация и документация. Вы видите запущенный код и результат, будь то просто текст, красиво отформатированная таблица или графический фигура. Документация может объяснить, что происходит, сделать их полезными. для учебных пособий.Ноутбуки по сути, более приятная интерактивная оболочка, в которой можно хранить команды и легко перезапустить с изменениями. Графика или выходы прямо в одном окна, а не сохраняются где-либо в файлах или всплывают в других окнах. Интерактивный сеанс можно сохранить в один файл и поделиться им, чтобы любой другой (при определенных условиях) может запустить его с теми же результатами.

Ноутбукихороши в двух вещах. Они делают хороший интерактивная оболочка для специалистов по данным, выполняющих интерактивную исследовательскую работу.Они также хороши для демонстраций. Они не являются решающими инструментами для выполнения наука о данных и многие специалисты по данным вообще не используют их.

Ноутбуки имеют много общих черт с электронными таблицами и тех же сильных и слабых сторон. Во-первых, сильные стороны. Они разрешают люди без особых навыков программирования, чтобы делать полезные количественная работа. Блокноты — это, по сути, сценарии, а сценарии — это первый шаг в общем программировании. Например, Excel позволяет создавать сценарии а также, например, с помощью формул.И на самом деле можно сделать много полезная работа с операциями перетаскивания. Оба они — инструменты, которые объединить проблемы хранения (как кода, так и данных), визуализации и бизнес-логика в одном приложении.

Наличие одного инструмента в качестве универсального решения для нескольких проблем имеет преимущества и недостатки. Преимущество — простота для простых вещей. Зачем мне просто использовать базу данных, приложение Java и интерфейс Javascript? проделать несложные операции по расчету заработной платы для дюжины сотрудников, которых я нанимаю в свой стартап? Вот чем хороши электронные таблицы в.Но это не означает, что для расчета заработной платы для крупный международный банк. И они для этого не используются, навсегда причины. Эти ситуации более сложные. Есть еще много переменных. У них есть требования к аудиту. Данные могут быть довольно большими и т. Д.

Команды людей могут успешно создавать большие приложения для решения сложные проблемы, но только если они могут контролировать эту сложность. И у нас есть очень мало инструментов для этого. Самое главное — разбить его на много меньших, менее связанных проблем.Вот почему в Шаблон расслоения данных домена представления, мы отдельный пользовательский интерфейс, логика домена и хранилище. Мы можем сосредоточиться на том, как выполняется расчет выполняется, не отвлекаясь на то, как это будет отображаться или как данные доступен.

Включение ноутбука в производственный конвейер эффективно ставит все экспериментальный код в производственную кодовую базу. Большая часть этого кода не имеет отношение к производственному поведению, и, таким образом, запутает людей, доработки в будущем.Ноутбук также представляет собой полноценную оболочку, которая опасно включать в производственную систему. Безопасные операции требуют воспроизводимость и проверяемость и, как правило, избегает ручной работы в производственная среда. Даже люди с благими намерениями могут ошибиться и причинить непреднамеренный вред.

Что нам нужно ввести в производство, так это заключительную логику предметной области и (иногда) визуализации. В большинстве случаев это несложно, поскольку большинство ноутбуков не так уж и сложны.Они поощряют только линейное написание сценариев, что обычно маленький и легкий для извлечения и включения в полную кодовую базу. Если это больше сложный, как мы вообще узнаем, что это работает? Эти скрипты подходят для некоторых строк кода, но не десятками. Вы обычно хотите разбить это на более мелкие, модульные и тестируемые, чтобы вы могли быть уверены, что действительно работает и, возможно, позже, повторно использовать код для других целей без дублирование.

Итак, мы утверждали, что запуск ноутбуков непосредственно в производстве обычно это не так полезно или безопасно.Также несложно включить в структурированная кодовая база. Так почему кто-то вообще говорит о том, как производить ноутбуки? Суть проблемы в том, что специалисты по данным и разработчики программного обеспечения не всегда очень хорошо общаются или понимают что нужно сделать другому. Многие специалисты по данным не совсем понимают проблемы профессиональных разработчиков программного обеспечения, таких как автоматизированное, воспроизводимые и проверяемые сборки или необходимость и процесс тщательного тестирование, или важность хорошего дизайна для поддержки кодовых баз и гибкий.В свою очередь, многие разработчики программного обеспечения не очень понимают что делают специалисты по данным.

Хотя два типа людей часто могут хорошо работать вместе без понимание деталей того, что должен делать другой, обычно не одна из тех ситуаций. Когда данные ученые и разработчики могут поделиться знаниями и узнать немного больше о что должен делать другой и почему они делают то, что делают. Это для говорят, что специалисты по данным должны стремиться изучать разработку программного обеспечения и работать в полную силу встроен в группу доставки, отвечающую за доставку продукции программное обеспечение .В этом отношении им не нужно выходить на полную мощность, но они должны полностью понимать основы и продолжать учиться в наиболее актуальных областях их работе в команде.

Они обнаружат, что, используя многие программные приемы, развитие фактически делает их более продуктивными как аналитики данных. Они будут обнаруживают, что они могут справляться с более сложными задачами и тратить гораздо меньше времени на отладку когда они правильно структурируют код. Разработчики обнаружат, что они могут сделать гораздо лучше использовать модели и методы науки о данных, когда они не торопятся чтобы понять немного больше о том, что на самом деле происходит.Ни нужно чтобы стать полностью квалифицированными в другой области, но они должны, по крайней мере, быть компетентными в его основах.

Блокноты— полезные инструменты для интерактивного исследования данных, доминирующая деятельность специалиста по данным, работающего на ранней стадии нового проектировать или исследовать новую технику. Но как только подход был решен дальше, необходимо сместить акцент на построение структурированной кодовой базы вокруг этого подход, сохраняя при этом некоторую способность экспериментировать.Ключ в том, чтобы построить возможность экспериментировать с самим конвейером. Примером может быть включая реестр моделей машинного обучения, который позволяет изменять параметры либо во время выполнения, либо во время сборки и хранят такие результаты, как показатели производительности в хранилище данных. Это имеет то преимущество, что эксперименты всегда повторяются, поскольку они работают с версионным кодом, и их результаты сохранены для целей сравнения, а также в качестве очевидных маркеров прогресс. Это гарантирует, что любое различие в эффекте может быть продемонстрировано происходят по намеренной причине, что является отличительной чертой любого хорошего эксперимента.В конце концов, цель состоит в том, чтобы узнать, какие изменения в производственном программном обеспечении создать большую ценность для бизнеса. Чем меньше разрыв между средой эксперимент и реальная реализация, тем больше мы можем быть уверены что изменение действительно создает ценность. Еще одна ключевая идея — собрать данные научные конвейеры, чтобы они могли работать в нескольких средах, например, на производственные серверы, на сервере сборки и в локальных средах, таких как ваш ноутбук. Это дает еще больше возможностей для экспериментов без нарушение всего, что происходит в производстве.

В заключение, мы считаем, что обсуждение того, как производить данные научные тетради упускают суть. Цель должна заключаться в расширении возможностей данных ученые и все их команды по доставке собираются вместе и создают программное обеспечение, которое обеспечивает необходимую бизнес-функциональность, но при этом сохраняя способность экспериментировать и совершенствоваться. Это требует выезда из разработка стиля ноутбука после начальной фазы исследования, а не сделать его непрерывным образцом работы, требующим постоянной интеграции служба поддержки.Такой способ работы не только позволяет специалистам по обработке данных продолжать чтобы улучшить работающее программное обеспечение, он включает их в ответственность предоставление работающего программного обеспечения и реальной ценности для их бизнеса заинтересованные стороны.

Обзор различных подходов к внедрению моделей машинного обучения (ML) в производство | Жюльен Кервизич | Взлом Analytics

Фото Мантаса Хестхавена на UnsplashСуществуют разные подходы к внедрению моделей в производство, с преимуществами, которые могут варьироваться в зависимости от конкретного варианта использования.Возьмем, к примеру, вариант использования прогнозирования оттока: есть ценность в наличии статического значения, которое можно легко найти, когда кто-то звонит в службу поддержки клиентов, но есть некоторая дополнительная ценность, которую можно получить, если для определенных событий модель может быть повторно запущен с вновь полученной информацией.

Как правило, существуют разные способы обучения и использования моделей в производстве:

- Поезд : разовое, пакетное и в режиме реального времени / онлайн-обучение

- Обслуживание: Пакетное, в реальном времени (триггер базы данных, Pub / Sub, web-service, inApp)

Каждый подход имеет свой собственный набор преимуществ и компромиссов, которые необходимо учитывать.

Модели не обязательно должны проходить постоянное обучение, чтобы их можно было запустить в производство. Довольно часто специалист по анализу данных может просто обучить модель и запускать ее в производство до тех пор, пока ее производительность не ухудшится настолько, что потребуется обновить ее.

От Jupyter к Prod

Специалисты по обработке данных, создающие прототипы и выполняющие машинное обучение, обычно работают в предпочитаемой ими среде Jupyter Notebooks. По сути, расширенный графический интерфейс на repl, который позволяет сохранять как код, так и выходные данные команд.

Используя этот подход, более чем возможно перенести специальную обученную модель из некоторого фрагмента кода в Jupyter в рабочую среду. Различные типы библиотек и другие поставщики записных книжек помогают еще больше связать связь между рабочей средой Data Science и производством.

Формат модели

Pickle преобразует объект Python в битовый поток и позволяет сохранить его на диск и перезагрузить позже. Он обеспечивает хороший формат для хранения моделей машинного обучения при условии, что их предполагаемые приложения также являются встроенными в Python.

ONNX, формат обмена открытой нейронной сетью — это открытый формат, который поддерживает хранение и перенос прогнозных моделей между библиотеками и языками. Большинство библиотек глубокого обучения поддерживают его, и sklearn также имеет расширение библиотеки для преобразования своей модели в формат ONNX.

PMML или язык разметки прогнозных моделей — еще один формат обмена для прогнозных моделей. Как и для ONNX, в sklearn есть еще одно расширение библиотеки для преобразования моделей в формат PMML. Однако у него есть недостаток в том, что он поддерживает только определенные типы моделей прогнозирования.PMML существует с 1997 года и поэтому имеет большое количество приложений, использующих этот формат. Такие приложения, как SAP, например, могут использовать определенные версии стандарта PMML, а также для приложений CRM, таких как PEGA.

POJO и MOJO — это формат экспорта h3O.ai, который предлагает легко встраиваемую модель в приложение Java. Однако они очень специфичны для использования платформы h3O.

Обучение

Для одноразового обучения моделей модель может быть обучена и настроена специально специалистами по данным или обучаться с помощью библиотек AutoML.Однако наличие легко воспроизводимой настройки помогает перейти к следующему этапу производства, то есть к пакетному обучению.

Хотя это не является полностью необходимым для внедрения модели в производство, пакетное обучение позволяет нам иметь постоянно обновляемую версию вашей модели на основе последнего поезда.

Пакетное обучение может значительно выиграть от фреймворков типа AutoML. AutoML позволяет выполнять / автоматизировать такие действия, как обработка функций, выбор функций, выбор модели и оптимизация параметров.Их недавние результаты были на одном уровне или даже лучше самых прилежных специалистов по анализу данных.

Linkedin postИспользование их позволяет проводить более полное обучение модели, чем то, что обычно делалось до их восхождения: просто переобучение весов модели.

Существуют различные технологии, которые созданы для поддержки этого непрерывного пакетного обучения, они могут, например, быть настроены с помощью сочетания воздушного потока для управления различными рабочими процессами и библиотекой AutoML, такой как tpot ,. Различные поставщики облачных услуг предлагают свои решения для AutoML, которые можно использовать в рабочем процессе обработки данных.Например, Azure объединяет прогнозирование машинного обучения и обучение модели со своим предложением фабрики данных.

Обучение в реальном времени возможно с помощью моделей «машинного обучения онлайн». Алгоритмы, поддерживающие этот метод обучения, включают K-средних (через мини-пакет), линейную и логистическую регрессию (через стохастический градиентный спуск), а также наивный байесовский классификатор.

Spark имеет StreamingLinearAlgorithm / StreamingLinearRegressionWithSGD для выполнения этих операций; sklearn имеет SGDRegressor и SGDClassifier, которые можно обучать постепенно.В sklearn инкрементное обучение выполняется с помощью метода partial_fit, как показано ниже:

При развертывании модели этого типа требуется серьезная оперативная поддержка и мониторинг, поскольку модель может быть чувствительной к новым данным и шуму, а также к производительности модели. нужно отслеживать на лету. В автономном обучении вы можете отфильтровать точки с высоким уровнем воздействия и исправить этот тип входящих данных. Это намного сложнее сделать, когда вы постоянно обновляете обучение модели на основе потока новых точек данных.

Еще одна проблема, которая возникает при обучении онлайн-моделей, заключается в том, что они не искажают историческую информацию. Это означает, что в случае структурных изменений в наборах данных модель в любом случае потребуется повторно обучить, и что на управление ее жизненным циклом будет возложена большая ответственность.

При выборе того, следует ли настроить прогнозирование в режиме реального времени или пакетное, важно понять, почему важно делать прогнозирование в реальном времени. Потенциально это может быть для получения новой оценки, когда происходят важные события, например, это будет оценка оттока клиентов, когда они звонят в контакт-центр.Эти преимущества необходимо сопоставить со сложностью и финансовыми последствиями, возникающими при прогнозировании в реальном времени.

Влияние на нагрузку

Предсказание в реальном времени требует способа справиться с пиковой нагрузкой. В зависимости от принятого подхода и того, как в конечном итоге используется прогноз, выбор подхода в реальном времени также может потребовать наличия машины с дополнительной вычислительной мощностью, доступной для обеспечения прогнозирования в рамках определенного SLA. Это контрастирует с пакетным подходом, когда вычисления прогнозов могут быть распределены в течение дня в зависимости от доступной мощности.

Влияние на инфраструктуру

Переход на работу в реальном времени подразумевает гораздо более высокую операционную ответственность. Людям необходимо иметь возможность отслеживать, как работает система, получать предупреждения о проблемах, а также принимать во внимание ответственность за аварийное переключение. Для пакетного прогнозирования операционные обязательства намного ниже, определенно необходим некоторый мониторинг и желательно внесение изменений, но необходимость знать о проблемах, возникающих напрямую, гораздо меньше.

Последствия для затрат

Прогнозирование в реальном времени также имеет финансовые последствия, необходимость в большей вычислительной мощности, невозможность распределить нагрузку в течение дня может вынудить к покупке большей вычислительной мощности, чем вам нужно, или к оплате рост спотовой цены. В зависимости от принятого подхода и требований, здесь также могут возникнуть дополнительные расходы из-за необходимости более мощной вычислительной мощности для SLA. Кроме того, при выборе прогнозов в реальном времени, как правило, требуется больший объем инфраструктуры.Одно из возможных предупреждений заключается в том, что выбор делается в пользу прогнозов в приложении. Для этого конкретного сценария стоимость может оказаться дешевле, чем при пакетном подходе.

Значение оценки

Оценка эффективности прогнозирования в режиме реального времени может быть более сложной задачей, чем при пакетном прогнозировании. Как вы оцениваете производительность, когда сталкиваетесь с последовательностью действий в течение короткого периода времени, дающего, например, несколько прогнозов для данного клиента? Оценить и отладить модели прогнозирования в реальном времени значительно сложнее.Им также требуется механизм сбора журналов, который позволяет собирать различные прогнозы и характеристики, которые дали оценку для дальнейшей оценки.

Пакетные прогнозы основаны на двух разных наборах информации, один — это прогнозная модель, а другой — функции, которые мы будем использовать в модели. В большинстве типов архитектуры пакетного прогнозирования ETL выполняется либо для получения предварительно рассчитанных функций из определенного хранилища данных (хранилища функций), либо для выполнения некоторого типа преобразования в нескольких наборах данных, чтобы предоставить входные данные для модели прогнозирования.Затем модель прогнозирования выполняет итерацию по всем строкам в наборах данных, обеспечивая другую оценку.

пример потока для модели, служащей для пакетного прогнозированияПосле того, как все прогнозы были вычислены, мы можем «передать» оценку различным системам, желающим использовать информацию. Это можно сделать по-разному в зависимости от варианта использования, для которого мы хотим использовать оценку, например, если мы хотим использовать оценку во внешнем приложении, мы, скорее всего, отправим данные в «кеш». »Или базы данных NoSQL, такой как Redis, чтобы мы могли предлагать ответы в миллисекундах, в то время как для определенных случаев использования, таких как создание пути электронной почты, мы могли бы просто полагаться на экспорт CSV SFTP или загрузку данных в более традиционную СУБД.

Чтобы запустить модель в производство для приложений реального времени, необходимы три основных компонента. Профиль клиента / пользователя, набор триггеров и прогнозных моделей.

Профиль: Профиль клиента содержит все атрибуты, связанные с клиентом, а также различные атрибуты (например, счетчики), необходимые для того, чтобы сделать данный прогноз. Это необходимо для прогнозирования на уровне клиента, чтобы уменьшить задержку при извлечении информации из нескольких мест, а также упростить интеграцию моделей машинного обучения в производство.В большинстве случаев подобный тип хранилища данных потребуется для эффективного извлечения данных, необходимых для работы модели прогнозирования.

Триггеры: Триггеры — это события, вызывающие запуск процесса. Они могут быть в случае оттока клиентов, таких событий, как звонок в центр обслуживания клиентов, проверка информации в истории заказов и т. Д.

Модели: модели должны быть предварительно обучены и обычно экспортируются в один из форматов. ранее упоминалось (pickle, ONNX, PMML…), что мы могли бы легко перенести в производственную среду.

Существует довольно много различных подходов к размещению моделей для целей оценки в производственной среде:

- Опираясь на интеграцию в базе данных: многие поставщики баз данных приложили значительные усилия, чтобы связать варианты использования расширенной аналитики в базе данных. . Будь то прямая интеграция кода Python или R с импортом модели PMML.

- Использование модели Pub / Sub : Модель прогнозирования, по сути, представляет собой приложение, загружающее поток данных и выполняющее определенные операции, такие как получение информации профиля клиента.

- Webservice: Настройка оболочки API для прогнозирования модели и развертывание ее как веб-службы. В зависимости от того, как настроен веб-сервис, он может или не может выполнять вытягивание или данные, необходимые для питания модели.

- inApp: также можно развернуть модель непосредственно в собственном или веб-приложении и запустить модель на локальных или внешних источниках данных.

Интеграция с базой данных

Если общий размер вашей базы данных довольно невелик (<1 млн пользовательских профилей) и частота обновления является случайной, имеет смысл интегрировать некоторые процессы обновления в реальном времени непосредственно в базу данных.

Postgres обладает интеграцией, которая позволяет запускать код Python как функции или хранимую процедуру, называемую PL / Python. Эта реализация имеет доступ ко всем библиотекам, которые являются частью PYTHONPATH , и поэтому может использовать библиотеки, такие как Pandas и SKlearn, для выполнения некоторых операций.

Это может быть связано с механизмом триггеров Postgres для выполнения запуска базы данных и обновления показателя оттока. Например, если в таблицу жалоб вносится новая запись, было бы полезно повторно запустить модель в реальном времени.

Поток последовательности

Поток можно настроить следующим образом:

Новое событие: Когда новая строка вставляется в таблицу жалоб, генерируется триггер события.

Триггер: Функция триггера обновит количество жалоб, поданных этим клиентом, в таблице профиля клиента и получит обновленную запись для клиента.

Запрос на прогноз: На основе этого он повторно запустит модель оттока через PL / Python и получит прогноз.

Обновление профиля клиента: Затем он может повторно обновить профиль клиента с обновленным прогнозом. Затем могут возникнуть нисходящие потоки после проверки того, был ли профиль клиента обновлен новым прогнозным значением оттока.

Technologies

Различные базы данных могут поддерживать выполнение сценария Python, это случай PostGres, который имеет встроенную интеграцию Python, как упоминалось ранее, но также и Ms SQL Server через его службу машинного обучения (в базе данных ), другие базы данных, такие как Teradata, могут запускать сценарий R / Python с помощью внешней команды сценария.В то время как Oracle поддерживает модель PMML через расширение интеллектуального анализа данных.

Pub / Sub

Реализация прогнозирования в реальном времени с помощью модели pub / sub позволяет правильно управлять нагрузкой за счет регулирования. Для инженеров это также означает, что они могут просто передавать данные о событиях через один канал «журналирования», на который могут подписаться различные приложения.

Пример того, как это можно настроить, показан ниже: